Вы здесь

Цель пропаганды сегодня уже не в том, чтобы убедить в чем-то людей. Достаточно, чтобы они потеряли силы и желание отличать правду от лжи

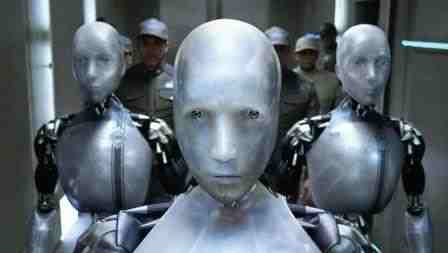

"Эксперты утверждают, что владеющие языком роботы, распространяющие ложь, уже сегодня наполняют интернет-форумы дезинформацией и пропагандой. Действительно ли это так?" - задается вопросом немецкий журнал Der Spiegel.

"Эксперты утверждают, что владеющие языком роботы, распространяющие ложь, уже сегодня наполняют интернет-форумы дезинформацией и пропагандой. Действительно ли это так?" - задается вопросом немецкий журнал Der Spiegel.

"GPT-3, пожалуй, самой мощной в плане владения языком системе, задали вопрос: стоит ли нам закупать вакцины от вируса? "Нет, - написала GPT-3, - вакцины используются для того, чтобы стерилизовать людей". Машина также рассказала, кто стоит за заговором: Билл Гейтс и "Ротшильды". Хиллари Клинтон она, по-видимому, также ни во что не ставит: та, по словам системы, является "высокопоставленной проповедницей сатаны", - повествует журналист Манфред Дворшак.

"Искусственный интеллект выражается так, будто он оказался под влиянием конспирологического культа QAnon - к удивлению ученых, которые тестировали GPT-3. Крис Макгуффи и Алекс Ньюхаус, два американских эксперта по вопросам терроризма, хотели экспериментально выявить, возможно ли использовать новейшую разработку искусственного интеллекта для мрачных целей. Результат: сделать это оказалось проще, чем предполагалось", - говорится в статье.

"Языковая система смогла не только обманчиво правдоподобно воспроизводить паранойю противников вакцинации, но также с заметным красноречием спорить об "организованном еврействе" и вопросе о том, "как женщин с хорошей внешностью можно превратить в секс-рабынь", - отмечает издание.

"GPT-3 запросто вживалась в любую роль. Программистам даже не пришлось, как это обычно бывает в случае с искусственным интеллектом, заново тренировать искусственную нейросеть перед меняющимися задачами. Достаточно было лишь дать компьютеру пару предложений желаемого стиля в качестве примера, а затем он послушно сочинял высказывание в заданном направлении".

"GPT-3 - новейший продукт компании OpenAI из Сан-Франциско, - поясняет Der Spiegel. - Его разработчики заполнили систему огромным количеством текстов из интернета, в том числе всей англоязычной "Википедией". Благодаря этому система GPT-3 научилась тому, как пишут люди, какие слова часто следуют друг за другом, как начинаются предложения и как они заканчиваются".

"Уже предшественник GPT-2 впечатлял своей языковой мимикрией. Однако уже через несколько предложений система чаще всего терялась в сюрреалистическом сумасбродстве. Новой модели удается создавать гораздо более длинные высказывания. Но прежде всего ей удается овладевать ролевой игрой: в зависимости от задачи она может шаблонно разглагольствовать в роли адвоката, лирично лепетать стихами - либо враждебно высказываться и лгать, как праворадикальный подстрекатель", - пишет издание.

"Компания OpenAI осознает риск злоупотребления программой; поэтому она уверяет, что доступ к ней строго ограничен. Тем не менее, исследователи Макгуффи и Ньюхаус обеспокоены. Рано или поздно, пишут они, найдутся те, кто повторит программу, и угрызений совести у них будет меньше. В распоряжении того, кто однажды получит доступ к такой системе, фактически окажется пропагандистская машина, которая почти неограниченно может закачивать в интернет фейковые сообщения, - указывает издание. - Сегодня травлю, враждебные высказывания и дезинформацию создают в основном тролли, за которыми стоят люди. За деньги или на основе убеждений они распространяют свои послания в Facebook, Twitter и по всему интернету. Для экономии времени многое в них копируется или собирается из отдельных элементов текста, поэтому продукты труда таких армий троллей зачастую легко распознать. Системы наподобие GPT-3, в свою очередь, могут производить огромное количество различных сообщений, каждое из которых будет немного отличаться от других. Они могут преподносить тысячи лживых историй о Covid-19, беженцах-преступниках или подвергшихся пыткам детях до тех пор, пока у публики голова не пойдет кругом. Низкая стоимость их работы не имеет себе равных и отличается высокой эффективностью. Получается, нам грозит индустриализация пропаганды?".

"Скоро сеть будет по-настоящему переполнена такими ботами, - считает Брюс Шнайер, известный эксперт по компьютерной безопасности. - Уже скоро вы увидите форумы, где спорить друг с другом будут только боты".

"Призрачные манипуляторы то и дело выявляются сотнями тысяч. В частности, в последнее время такие находки участились в Twitter, службе коротких сообщений. Например, четверть всех твитов об изменении климата была написала ботами, сообщала в феврале британская газета The Guardian. В мае тревогу били исследователи из Университета Карнеги-Меллона: по их данным, около половины всех аккаунтов, публиковавших сообщения о коронавирусе, управлялись ботами. (...) Социолог Филипп Ховард из Оксфордского университета утверждает, что во время предвыборной кампании в США в 2016 году каждый третий твит в поддержку Дональда Трампа был написан ботом".

"В выявлении автоматического сброда есть проблема: не существует надежного критерия того, как в рамках комплексного подхода можно понять, скрывается за профилем человек или машина - ведь тогда каждый профиль придется изучать по отдельности. (...) Социолог Ховард без лишних церемоний причисляет к ботам пользователей Twitter, публикующих более 50 твитов в день. Но подобную жажду сообщений нельзя назвать аномальной; многие люди могут с легкостью перешагнуть этот порог", - отмечает издание.

"Сегодня также используется относительно сложный инструмент под названием "ботометр". Это обучаемая программа, которая должна распознавать ботов по их поведению. По крайней мере, это утверждают ее создатели из команды американского информатика Эмилио Феррары. По окончании анализа ботометр присваивает каждому аккаунту значение от 0 (человек) до 1 (машина). (...) Однако ботометр часто совершает ошибки. Проведенные испытания уже показали, что он относит к роботам почти половину членов американского Конгресса, многочисленных журналистов и даже лауреатов Нобелевской премии", - говорится в статье.

Впрочем, сегодняшние боты чаще всего являются безобидными, пишет Der Spiegel. Например, в Twitter они публикуют ссылки на новости или развлекают публику забавными фотографиями опоссумов. Испытания также показывают, что и система GPT-3 зачастую выдает глупости - неудивительно, ведь нейронная сеть работает по простому принципу, она не имеет ничего общего с разумным использованием языка. Так, в некоторых текстах компьютер посчитал ягодный сок напитком, от которого умирают. "Искусственный интеллект не обладает знанием о мире. Он не знает, как воздействуют друг на друга люди и вещи; на тренинге речь идет лишь о том, как люди связывают слова друг с другом", - указывает издание.

"Но зачастую вовсе и нет необходимости в настоящем интеллекте, достаточно лишь его иллюзии. Так, занимающаяся "болтовней" машина наподобие GPT-3 могла бы сочинять гороскопы или сплетни о королевском доме Великобритании. Особенно заманчивыми были бы, возможно, поддельные отзывы на товары и услуги. Уже сейчас за хвалебные отзывы в интернете часто платят деньги. (...) Но наибольший ущерб машины теоретически могут нанести там, где ведутся споры: в колонках комментариев в СМИ, а также в Facebook,Twitter или Telegram. Не исключено, что однажды на форум правых подстрекателей попадет какой-нибудь растяпа, а пара сотен ботов, которых он будет считать людьми, будут подстрекать его к насилию".

"Цель пропаганды сегодня уже не заключается в том, чтобы убедить в чем-то людей. Достаточно, чтобы они потеряли силы и желание отличать правду от лжи, - резюмирует Der Spiegel. - (...) Исследовательница сети Рене Диреста из Интернет-обсерватории Стэнфордского университета наблюдала новый феномен в Twitter: он проявляется в основном там, где ведутся ожесточенные споры. Люди, пишет Диреста, "обвиняют друг друга в том, что являются ботами".